تحليل البيانات: كيف تتحوّل الأرقام إلى قرارات؟

في هذا المقال، نناقش تحليل البيانات بمراحله وأبعاده، من صياغة الفرضية إلى اتخاذ القرار، وتفكيك مفاهيم "البيانات كحقائق"، مدعومة بأمثلة واقعية ومنهجية حديثة باستخدام أدوات مثل ZdataCloud.

في زمن أصبحت فيه البيانات هي العملة الجديدة للمعرفة والسلطة، لم يعد امتلاك المعلومات كافيا، بل بات التحدي الأكبر هو القدرة على تحليلها، فهمها، وتوجيهها. في هذا المقال والذي يسعى إلى تفكيك مفهوم تحليل البيانات بمراحله المتسلسلة، وأدواته المتنوعة، وأبعاده المعرفية، بدءًا من تحديد الفرضيات، مرورًا بخطوات الجمع والتنظيم، وانتهاءً بما بعد التحليل: حيث تبدأ البصيرة، ويُصاغ القرار، ويُبنى المعنى. نحن لا نبحث عن رقم، بل عن ما يقف خلف الرقم من نسق، وما يُفهم منه من اتجاه، وما يمكن فعله به من تغيير.

المفهوم، الأنماط، والدلالة العلمية

في المشهد المعرفي المعاصر، لم يعد السؤال هو "هل لدينا بيانات؟" بل تحوّل إلى "كيف نُخضع هذه البيانات للفهم؟". لقد تضاعفت القدرة البشرية على جمع البيانات بدرجة فاقت قدرة المؤسسات على تفسيرها، مما أوجد فجوة معرفية حرجة: بين وفرة المعطيات، وندرة البصائر. وهنا تتجلى الحاجة إلى تحليل البيانات كأداة عقلية ومنهجية تُمكّننا من إضفاء البنية والمعنى على عالم رقمي يعج بالفوضى العددية.

ماهية البيانات وحدودها المفاهيمية

حين نصف "البيانات" بأنها "مجموعة من الحقائق"، فإننا نرتكب اختزالًا معرفيًا؛ لأن البيانات لا تكتسب طابع "الحقيقة" إلا في لحظة تأويلها وفق منهج علمي. فالرقم "38%" لا يعني شيئًا بذاته ما لم نعرف أنه يعبّر مثلًا عن نسبة الرضا لدى عينة من العملاء في قطاع الاتصالات، خلال فترة زمنية محددة، في سياق استبيان مصمم وفق شروط منهجية. دون ذلك، يظل الرقم رقمًا، معلقًا في فضاء من الاحتمال. البيانات هي انعكاس كمي أو وصفي لواقع معين، جُمعت تحت ظروف محددة، وبوسائل قابلة للمساءلة العلمية. وفي هذا السياق، يمكننا التمييز بين:

-

البيانات الكمية: مثل درجات الطلاب، عدد الزوار، نسب البطالة.

-

البيانات النوعية: مثل آراء الموظفين حول بيئة العمل، أو وصف مشاعر العملاء تجاه منتج جديد.

لكن مهما تنوّعت أشكال البيانات، فإن قيمتها لا تُستخرج من ذاتها، بل من التحليل الذي يُجرى عليها.

تحليل البيانات كعملية عقلية ومنهجية

تحليل البيانات ليس مجرّد تشغيل برنامج، أو تمرير معادلات، بل هو سلسلة من المواقف المعرفية تبدأ بالسؤال وتنتهي بالتفسير. إنه "إعادة تشكيل" للواقع الرقمي بطريقة تسمح باستخلاص الأنماط، وقياس العلاقات، وتوليد التنبؤات، وتبرير القرارات. ففي دراسة طبية مثلًا تهدف إلى معرفة أثر نمط النوم على أداء الموظفين، يبدأ التحليل من السؤال العلمي: هل عدد ساعات النوم يؤثر في الكفاءة الإنتاجية؟ ثم يُبنى عليه تصميم البيانات: عدد ساعات النوم، مؤشر الأداء، العوامل المتداخلة. وأخيرًا، يُجري التحليل لتحديد إذا ما كانت العلاقة سببًا أم مجرد ارتباط.

أنماط تحليل البيانات

1. التحليل الوصفي (Descriptive Analysis)

يقف على حدود الملاحظة دون أن يعبر إلى التفسير. يُستخدم لتلخيص خصائص الظاهرة:

-

مثال: شركة تبحث في أداء موظفيها خلال السنة المالية، تستخرج معدل الحضور الشهري، عدد ساعات العمل الإضافي، وتكرار التغيب.

-

الأدوات: المتوسط الحسابي، النسب، الانحراف المعياري، الرسوم البيانية.

2. التحليل الاستكشافي (Exploratory Analysis)

لا ينطلق من فرضيات مسبقة، بل يترك المجال مفتوحًا للبيانات لتكشف عما لم يكن متوقعًا:

-

مثال: منصة تعليمية تستعرض سلوك الطلاب داخل النظام الرقمي، فتكتشف أن نسبة التفاعل ترتفع في منتصف الأسبوع أكثر من بدايته ونهايته، مما يفتح بابًا لفهم أنماط التفاعل المرتبطة بالأيام.

-

الأدوات: المخططات العنقودية، تحليل الارتباط، تقنيات التصوير البياني.

3. التحليل التنبؤي (Predictive Analysis)

يسعى إلى بناء نموذج يقرأ المستقبل بناءً على معطيات الماضي:

-

مثال: شركة تأمين تستخدم بيانات تاريخية (العمر، الحالة الصحية، سجل الحوادث) لبناء نموذج يتنبأ باحتمالية مطالبة العميل بتعويض خلال العام القادم.

-

الأدوات: الانحدار الخطي واللوجستي، خوارزميات تعلم الآلة، أشجار القرار.

4. التحليل الاستنتاجي (Inferential Analysis)

يحاول تعميم نتائج عينة على مجتمع الدراسة الأكبر:

-

مثال: دراسة أجريت على عينة من طلاب جامعة واحدة لاختبار فاعلية طريقة تدريس جديدة، ويتم تعميم النتائج ـ تحت شروط منهجية معينة ـ على طلاب الجامعات المماثلة.

-

الأدوات: اختبار "t"، تحليل التباين (ANOVA)، فترات الثقة.

5. التحليل السببي (Causal Analysis)

يركز على اختبار الفرضيات السببية ضمن شروط صارمة:

-

مثال: باحث يريد التأكد إن كانت ساعات العمل الطويلة تؤدي إلى تراجع في الإنتاجية، لا يكتفي بملاحظة العلاقة، بل يُجري تجربة ميدانية يتحكم فيها في المتغيرات الخارجية.

-

الأدوات: تصميم التجارب العشوائية، النمذجة السببية، تحليل المسار (Path Analysis).

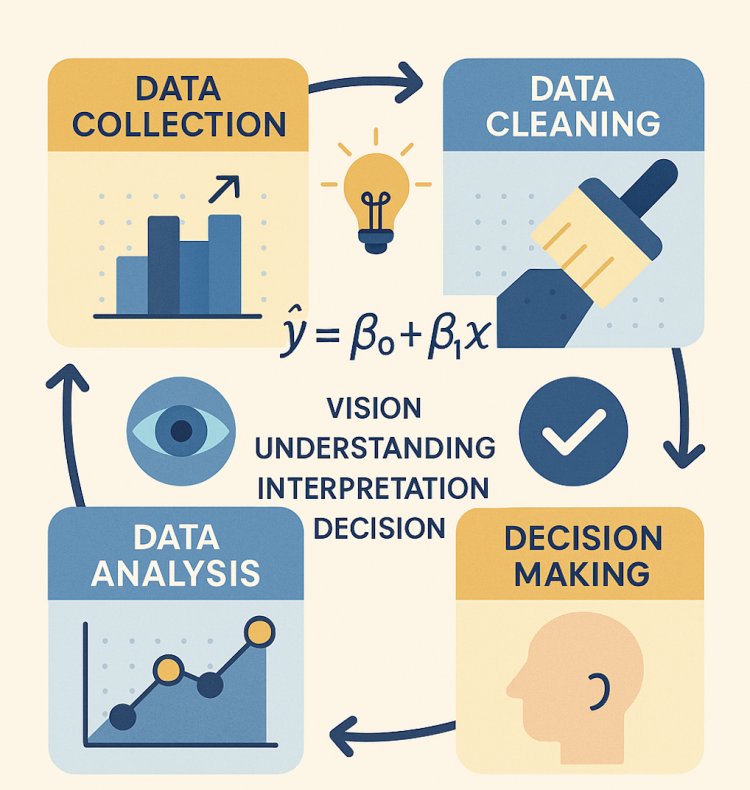

خطوات تحليل البيانات من داخل البرامج الإحصائية

حين ننتقل من المفهوم إلى الممارسة، ومن التنظير إلى التطبيق، تبدأ الأسئلة الأكثر حساسية بالظهور: كيف نحلل البيانات فعليًا؟ وما هي الخطوات التي نمر بها داخل البيئة الإحصائية؟ وهل اختيار البرنامج الإحصائي ـ مثل SPSS أو Python أو R ـ يُحدد جودة التحليل أم أن المنهج أسبق من الأداة؟

التحليل لا يبدأ بفتح البرنامج، بل بالسؤال الذي نصوغه، والفرضية التي نختبرها، والمنهج الذي نلتزم به. أما البرامج الإحصائية فهي مجرد وسائط لتنفيذ ذلك المنهج بلغة دقيقة. لذلك، فإن فهم خطوات تحليل البيانات يجب أن ينبع من المنهج العلمي أولًا، ثم يُترجم إلى ممارسات إجرائية في بيئات التحليل المختلفة.

تحديد الهدف والفرضية

لا يبدأ تحليل البيانات حين تُفتح صفحة Excel أو يُطلق كود في بيئة برمجية، بل يبدأ من لحظة ما قبل البيانات ذاتها؛ من الرغبة في الفهم، ومن الدهشة التي تطرح سؤالًا يسبق الرقم. إن تحديد الهدف والفرضية لا يُعد خطوة إجرائية فقط، بل هو فعلٌ فكريّ بامتياز، يُشكّل الإطار العقلي والمنهجي لكل ما سيتبع. في هذا السياق، يجب التمييز بين ثلاثة مستويات من الانطلاق:

-

السؤال البحثي (Research Question)

ما الذي نريد أن نعرفه؟ السؤال الجيد يكون دقيقًا، قابلًا للقياس، ومتصلاً بسياق معرفي واضح.-

مثال: "هل هناك علاقة بين نمط النوم وجودة القرار الإداري؟"

-

-

الفرضية (Hypothesis)

ترجمة السؤال إلى توقع إحصائي قابل للاختبار. والفرضية هنا ليست تخمينًا، بل بناء معرفي مستند إلى نظرية أو ملاحظة.-

مثال: "نمط النوم المتقطع يؤدي إلى انخفاض في دقة اتخاذ القرار لدى المديرين التنفيذيين."

-

-

أهمية المشكلة (Problem Significance)

لماذا نطرح هذا السؤال أصلًا؟ ما قيمة الإجابة عنه؟ وما الذي ستغيره النتيجة إن تأكدت أو نُقضت؟-

قد تكون الدوافع: تحسين أداء، تقليل تكلفة، فهم ظاهرة، توجيه سياسة.

-

هذا الثلاثي — السؤال، الفرضية، الأهمية — هو ما يُحدد لاحقًا:

-

نوع البيانات التي يجب جمعها.

-

شكل العينة المستهدفة.

-

واختيار البرنامج الإحصائي الأنسب لتحليل النتائج.

أمثلة تطبيقية متنوعة

• مثال بحثي في السياق الصحي:

-

السؤال: "هل يؤثر مستوى النشاط البدني على ضغط الدم لدى كبار السن؟"

-

الفرضية: "الانخفاض في النشاط البدني يرتبط بارتفاع مستوى ضغط الدم."

-

الأهمية: توجيه برامج الصحة الوقائية وتعزيز أنماط الحياة الصحية.

• مثال تطبيقي في قطاع الأعمال:

-

السؤال: "ما العوامل التي تزيد من احتمالية انسحاب العملاء الجدد خلال أول ٣ أشهر؟"

-

الفرضية: "قلة التفاعل مع الدعم الفني ترتبط بارتفاع احتمالية الانسحاب."

-

الأهمية: تحسين خدمات ما بعد البيع وتقليل معدل تسرّب العملاء.

• مثال في التعليم:

-

السؤال: "هل تؤثر أساليب التعلم الذاتي على تحصيل الطلاب في المواد العلمية؟"

-

الفرضية: "الطلاب الذين يعتمدون على أسلوب الفيديوهات التفاعلية يحققون معدلات أعلى."

-

الأهمية: إعادة تصميم المناهج الرقمية والتوجيه التربوي.

جمع البيانات وتنظيمها

إذا كان تحديد الهدف والفرضية هو البناء العقلي للتحليل، فإن جمع البيانات هو ترجمته الواقعية، حيث تتحول التساؤلات المجردة إلى عناصر قابلة للقياس، والملاحظات إلى متغيرات يمكن تتبعها، والواقع إلى صفوف وأعمدة. ولكن جمع البيانات ليس عملية ميكانيكية، بل يخضع لجملة من الاعتبارات المنهجية والمعايير الأخلاقية، ويختلف باختلاف نوع الدراسة (كمية أم نوعية)، ومصدر البيانات (أولية أم ثانوية)، والبيئة التي يتم فيها الجمع (تجريبية أم طبيعية).

طرق جمع البيانات

تتعدد الوسائل التي يُمكن من خلالها جمع البيانات، ويقع اختيار الأداة المناسبة بناءً على طبيعة السؤال البحثي:

-

الاستبيانات (Questionnaires):

الأكثر شيوعًا في الدراسات الاجتماعية والنفسية، وتتيح جمع كميات كبيرة من البيانات في وقت قصير، خاصة إذا صُممت رقميًا. -

المقابلات (Interviews):

تعطي بيانات نوعية غنية، لكنها تتطلب وقتًا أطول، وتُستخدم غالبًا في الدراسات الاستكشافية أو التفسيرية. -

الملاحظة (Observation):

أداة مباشرة لرصد السلوك في بيئته الطبيعية، مع أهمية توثيق المعايير وأسلوب الرصد. -

السجلات والبيانات الثانوية:

مثل بيانات المستشفيات، أو قواعد بيانات العملاء، تُستخدم في التحليل التتبعي أو الطولي.

ZdataCloud: منصة متخصصة لجمع البيانات الإلكترونية

ضمن أدوات جمع البيانات الرقمية، تبرز منصّة ZdataCloud بوصفها بيئة ذكية ومرنة لجمع البيانات الكمية وفق أعلى المعايير البحثية.

توفر المنصة ما يلي:

-

أخذ عينات منضبط (Sampling Engine): عبر الحصص السكانية أو التوزيع العشوائي.

-

أسئلة مشروطة (Logic-Based Questions): لضمان تناسق المسارات داخل الاستبيان.

-

التحقق من الأهلية (Eligibility Filters): يمنع دخول من لا تنطبق عليهم شروط الدراسة.

-

مخرجات جاهزة للتحليل: تُصدر البيانات بصيغ CSV أو Excel مع كتيب رموز (codebook) يسهل التعامل معه داخل برامج SPSS أو Python أو R.

تنظيم البيانات بعد جمعها

ما إن يتم جمع البيانات، تبدأ مرحلة التنظيم والتحضير، والتي تشمل:

-

تحديد نوع المتغير (Variable Type): هل هو رقمي مستمر؟ ثنائي؟ اسمي؟

-

ترميز البيانات (Coding): خصوصًا في الاستجابات النوعية أو الإجابات النصية.

-

استبعاد العينات غير الصالحة: بسبب الإجابات العشوائية أو نقص الاستجابات أو تضاربها.

تنظيف البيانات ومعالجتها

بعد أن تُجمع البيانات وتُنظّم، لا تنتقل مباشرة إلى التحليل؛ بل تمرّ بمرحلة دقيقة وأساسية تُعرف بـ"تنظيف البيانات" أو Data Cleaning، وهي بمثابة الغربلة التي تزيل التشويش، وتمنع الانحرافات، وتمنح التحليل مصداقيته المنهجية. إن إهمال هذه الخطوة لا يقلّ خطرًا عن خطأ في التحليل ذاته، إذ يمكن لبيانات شاذة أو ناقصة أن تُنتج نتائج مضللة، أو استنتاجات خاطئة، أو ارتباطات زائفة، خصوصًا في الأبحاث ذات الحساسية التطبيقية (كالصحة، التعليم، السياسات العامة).

ماذا يشمل تنظيف البيانات؟

يتضمن هذا المسار مجموعة من العمليات التي تختلف في تفاصيلها حسب نوع البيانات، ولكنها تلتقي في هدف واحد: إعداد ملفّ خالٍ من التلوث الإحصائي.

1. معالجة القيم المفقودة (Missing Data):

-

إما بحذف السجلات الناقصة إذا كانت نسبتها منخفضة، أو عبر تقنيات الاستكمال الإحصائي (مثل المتوسط، أو التنبؤ الخطي).

2. كشف القيم الشاذة (Outliers):

-

مثل طالب سجّل "120 سنة" كعمر، أو عميل اشترى "1000 منتج" دفعة واحدة. هذه القيم تُراجع في ضوء السياق، وقد تُستبعد أو تُقيَّم وفق وزنها التأثيري.

3. توحيد التنسيقات والترميز (Recoding):

-

هل كُتب الجنس "ذكر/أنثى" أم "1/2"؟ هل الإجابات بنعم/لا، أم "موافق/غير موافق"؟

أي تناقض هنا يؤثر على إمكانية المعالجة والتحليل لاحقًا.

4. كشف التكرار (Duplicate Entries):

-

خصوصًا في المنصات المفتوحة، قد تُسجّل الإجابة نفسها أكثر من مرة، وهو ما يتطلب التصفية لضمان أصالة كل حالة.

5. التحقق من الاتساق المنطقي (Logical Consistency):

-

مثال: لا يمكن لشخص أن يُسجّل عمره 15 سنة ويجيب في الوقت نفسه عن "عدد سنوات الخبرة في سوق العمل".

دور البرامج الإحصائية في التنظيف

توفّر بيئات مثل SPSS أو Excel أدوات تنظيف جاهزة لكنها محدودة، فيما تتيح Python (pandas) وR (dplyr) مرونة أكبر، لكنها تتطلب خبرة برمجية. لكن تبقى جميع هذه البيئات خاضعة لجودة البيانات الأصلية؛ فكلما زادت الفوضى في الجمع، زادت تكلفة التنظيف لاحقًا.

ZdataCloud تجاوز مرحلة التنظيف

في هذا السياق، تبرز قيمة المنصات الذكية لجمع البيانات ـ وعلى رأسها ZdataCloud ـ التي تعيد تعريف العلاقة بين الجمع والتنظيف. إذ تُمكّن هذه المنصة الباحث من تصميم بيئة استبيانية تُجبر المستخدم على تقديم استجابات متناسقة، كاملة، وقابلة للترميز منذ اللحظة الأولى.

-

لا توجد استجابات ناقصة: لأن المنصة تفرض الإجابة على كل سؤال مطلوب.

-

لا توجد قيم خارج النطاق: بفضل المحددات الرقمية والفلاتر الشرطية.

-

لا حاجة لترميز يدوي: لأن كل متغير يُولد تلقائيًا بلغة جاهزة للتحليل.

-

لا تكرار غير مرصود: لأن المنصة تتحقق من الهوية الرقمية وتمنع التكرار.

وبالتالي، فإن استخدام منصة مثل ZdataCloud يُغني الباحث ـ أو يقلل إلى الحد الأدنى ـ من الحاجة إلى خطوات التنظيف اليدوية التي تستنزف الوقت، وتفتح الباب للأخطاء البشرية.

اختيار التحليل الإحصائي المناسب

بعد تنظيف البيانات ومعالجتها، يصبح السؤال المحوري هو: ما نوع التحليل الذي يتوجب استخدامه؟

هذا السؤال لا ينبغي أن يُطرح بوصفه خيارًا تقنيًا مجردًا، بل ينبغي أن يُربط بالسياق العلمي والهدف التحليلي؛ فليس كل تحليل يصلح لأي نوع من البيانات، ولا كل علاقة تُثبت بارتباط رقمي. التحليل الإحصائي الناجح لا يُقاس بمدى تعقيد المعادلة، بل بمدى دقته في الإجابة على السؤال البحثي ضمن شروطه المنهجية. وهنا تبرز أهمية فهم الفروق بين أنواع التحليل وأنواع المتغيرات، والعلاقة بينهما.

1. طبيعة المتغيرات

قبل اختيار نوع التحليل، يجب تصنيف المتغيرات محل الدراسة:

-

كمية مستمرة (Continuous): مثل العمر، الراتب، ضغط الدم.

-

كمية منفصلة (Discrete): مثل عدد الأطفال، عدد الزيارات.

-

نوعية اسمية (Nominal): مثل الجنس، الجنسية، نوع الوظيفة.

-

نوعية ترتيبية (Ordinal): مثل درجة الرضا (منخفض، متوسط، مرتفع).

نوع المتغير يُحدد لاحقًا ما إذا كان التحليل سيتضمن مقارنة، علاقة، تنبؤ، أو تعميم.

2. أشكال التحليل الإحصائي وتطبيقاتها

• التحليل الوصفي (Descriptive Statistics): الهدف هو تقديم وصف عددي للبيانات دون استنتاجات:

-

المتوسط الحسابي، الوسيط، الانحراف المعياري.

-

النسب والتكرارات.

-

يُستخدم مثلًا لوصف خصائص عينة من المعلمين في دراسة تربوية.

• اختبار الفروق (Comparison Tests): حين نرغب في مقارنة مجموعتين أو أكثر في متغير معين.

-

T-Test: لمقارنة متوسطين.

-

ANOVA: لمقارنة أكثر من مجموعتين.

-

يُستخدم مثلًا لاختبار فروق الدخل بين الذكور والإناث.

• اختبار العلاقة (Correlation): حين نسأل: هل هناك ارتباط بين متغيرين؟

-

Pearson إذا كانت البيانات كمية ومستوفية لشروط الخطية.

-

Spearman إذا كانت البيانات ترتيبية أو غير طبيعية.

• الانحدار والتنبؤ (Regression): عند محاولة التنبؤ بقيمة متغير من خلال متغير أو أكثر.

-

Linear Regression: لتوقع قيمة رقمية (مثل الراتب).

-

Logistic Regression: لتوقع حدث ثنائي (مثل احتمال الإصابة بمرض).

• التحليل الاستنتاجي (Inferential Statistics): لتعميم النتائج من العينة إلى المجتمع.

-

يشمل اختبارات الفرضيات، فترات الثقة، ومقارنة المتوسطات.

-

يُستخدم في الدراسات التي تسعى لاشتقاق تعميمات منهجية (مثل دراسات السوق أو الأبحاث الطبية).

• تحليل التباين السببي (Causal Analysis):

يتطلب وجود تصميم تجريبي دقيق.

-

يعتمد على التجارب العشوائية وضبط المتغيرات المتداخلة.

-

يُستخدم مثلًا لاختبار أثر دواء جديد مقارنة بعلاج تقليدي.

3. اختيار البرنامج الإحصائي المناسب

اختيار البرنامج لا يجب أن يُملى على الباحث من تفضيلات تقنية، بل بناءً على نوع التحليل المطلوب:

-

SPSS: الأفضل في التحليل الوصفي والاستنتاجي التقليدي.

-

R: أكثر مرونة في التحليل المتقدم وتصوير البيانات.

-

Python: الأقوى في النمذجة التنبؤية والتكامل مع البيانات الضخمة.

-

Excel: مفيد للتحليل البسيط، لكنه محدود في الاستنتاجي والتنبؤي.

منفذ التجربة بعد التحليل

إن انتهاء عملية تحليل البيانات لا يعني اكتمال المعرفة، كما لا يعني نضج القرار. بل كثيرًا ما تُنتج التحليلات، في غياب الفعل، وهمًا بالمعرفة. ولهذا فإن السؤال الحقيقي الذي ينبغي أن يُطرح في أعقاب كل تحليل عميق ليس: "ماذا أظهرت النتائج؟" بل: "ما الذي يمكن وما الذي ينبغي فعله بهذه النتائج؟" فمنفذ التجربة، أكان باحثًا أكاديميًا، أو محللًا في منظمة، أو خبيرًا في تطوير السياسات، لا يُقاس دوره بمدى إتقانه للأدوات التحليلية فحسب، بل بقدرته على تفسير النتائج ضمن واقعها، وربطها بالسياق، وترجمتها إلى خيارات استراتيجية قابلة للتنفيذ والتقييم.

1. الفعل كامتداد طبيعي للفهم

التحليل الإحصائي ليس نهاية الرحلة، بل نقطة انعطاف؛ لحظة تتحوّل فيها الأرقام من مجرد إشارات صامتة إلى إشعارات معرفية توجه المسار. وهذا التحول يتطلب جملة من المراحل اللاحقة:

-

التفسير التأويلي للنتائج:

فالأرقام لا تتكلم وحدها؛ هي بحاجة إلى عقلٍ يُفسر، ومجالٍ يُقارن فيه، ونظريةٍ تُسندها أو تُراجعها. -

التحقق من الدلالة العملية للنتائج:

فأن تكون النتيجة ذات دلالة إحصائية (p < 0.05) لا يعني بالضرورة أنها مهمة في الواقع. هل الفارق مهم بدرجة تستدعي تعديلًا في القرار؟ أم أنه طفيف رغم أهميته العددية؟ -

تحديد السيناريوهات المترتبة على النتائج:

هل تؤدي النتيجة إلى تغيير في السياسات؟ تعديل في التصميم؟ تطوير في التدريب؟ أم مجرد توصية للبحث القادم؟

2. المهارة المعرفية العليا لمنفذ التحليل

هنا تتجاوز مسؤولية منفذ التحليل نطاق التقنية، وتدخل في نطاق الحكم العقلي الرشيد. لأنه يمتلك:

-

قدرة على تمييز الأثر من الضجيج.

-

حساسية تجاه التحيّزات المحتملة في البيانات أو أدوات القياس.

-

وعي بحدود التعميم، ومدى صلاحيته عبر البيئات المختلفة.

3. الترجمة الاستراتيجية للنتائج

ليست كل نتيجة تصلح لأن تُحوّل إلى قرار مباشر. بعض النتائج قد تُستخدم لتأكيد ما هو قائم، وبعضها لتفنيده، وبعضها لصياغة فرضية جديدة أو مسار بديل. لكن في كل الحالات، لا بد من تحويل النتيجة إلى:

-

سردية تحليلية يمكن مشاركتها:

بلغة تناسب القارئ غير المتخصص، دون تفريط في الدقة العلمية. -

قرار تنفيذي أو تعديل إداري أو سياسة تطبيقية:

وهنا يظهر الفارق بين من يُجيد عرض النتائج، ومن يُحسن توظيفها في القرار. -

بنية معرفية قابلة للتراكم:

بحيث تُسهم النتائج في توسيع الأفق البحثي أو فتح مجالات للتحقيق الأعمق.

4. البناء فوق النتائج: العلم لا يتوقف

من الأخطاء الجوهرية أن يُتعامل مع التحليل كخاتمة. بل هو نقطة بناء.

على منفذ التجربة أن يسأل:

-

ما الأسئلة التي لم تُجب عليها هذه النتائج؟

-

ما الثغرات المنهجية التي ظهرت ويجب تلافيها؟

-

كيف يمكن توظيف البيانات الحالية لبناء تجربة أكثر نضجًا مستقبلاً؟

البيانات... بين الحقيقة والتمثيل

كثيرًا ما تُقدَّم البيانات في الخطاب العام على أنها "مجموعة من الحقائق التي تم تحليلها"، وكأنها موضوعية مطلقة، تُنقل من الواقع كما هو، وتُفهم كما ينبغي، وتُفسَّر بلا وساطة. ولكن هذه النظرة التبسيطية، رغم شيوعها، تُخفي وراءها إشكالًا عميقًا في فهم ماهية البيانات، وطبيعة الحقيقة، ودور التحليل نفسه. فالبيانات لا تصلنا كـ "حقائق" نهائية، بل كتمثيلات أولية، جزءية، مشروطة بسياق القياس، ومنهج التكوين، وهدف الجمع. إنها ليست الحقيقة، بل ما اخترناه لقياسها من الحقيقة.

البيانات ليست الحقيقة بل لغة عنها

حين نقول إن نسبة الرضا عن خدمة معينة هي 68%، لا نعني أن الحقيقة هي 68%. بل نعني أننا سألنا بطريقة معينة، لعينة معينة، في زمن معين، بأسئلة مُعدة سلفًا، ثم حصلنا على هذه النسبة. إن الرقم هنا ليس الحقيقة، بل ترجمة رقمية لموقف بشري في لحظة محددة. البيانات لا تلتقط الجوهر، بل تلتقط الظاهر القابل للقياس. هي محكومة بما يمكن التعبير عنه رقميًا.

-

لا يمكن للبيانات أن تعبر عن التردد، أو التناقض الداخلي، أو النوايا المؤجلة، ما لم تُصمم أداتها لذلك.

-

لا يمكنها أن تلتقط الديناميات الاجتماعية التي لا تُختزل في إجابات مغلقة.

ولهذا فإن كل بيانات هي "جزئية"، و"اختيارية"، و"قابلة للتأويل" أكثر مما نعتقد.

التحليل لا يكشف الحقيقة، بل يُعيد بنائها

التحليل الإحصائي ليس عدسة محايدة نُشاهد من خلالها الواقع، بل هو ممارسة تفسيرية تنطوي على اختيارات مستمرة:

-

أي المتغيرات سنربطها ببعض؟

-

كيف نُعرّف العلاقة؟ ارتباط؟ سبب؟ تأثير؟

-

ما الذي نعدّه مهمًا إحصائيًا؟ وما الذي نتجاهله؟

كل إجابة من هذه الأسئلة تُعيد تشكيل "الحقيقة الرقمية"، وتُوجّه مسار الفهم. وبذلك، فإن التحليل لا يُستخرج من البيانات كما تُستخرج المعادن من باطن الأرض، بل يُبنى فوقها كبناء معرفي له منطلقات ومنطق.

الحقيقة في البيانات مشروطة بالسياق

في الدراسات الاجتماعية والسلوكية خصوصًا، لا يمكن اعتبار أي رقم "حقيقة نهائية" إلا إذا:

-

فُسّر في ضوء البيئة الثقافية التي جاء منها.

-

قورن بأرقام مشابهة في سياقات أخرى.

-

رُبط بمؤشرات غير رقمية (كاللغة أو الخطاب أو التجربة الشخصية).

خذ مثلًا: إذا أظهرت البيانات أن "45% من الموظفين لا يشعرون بالتحفيز"، فهل يعني هذا أن المؤسسة تعاني خللًا؟

ليس بالضرورة. فالإجابة تعتمد على:

-

طبيعة العمل.

-

الثقافة التنظيمية.

-

الخلفية الاجتماعية للعاملين.

-

مستوى توقعاتهم من المؤسسة.

وبذلك، لا تصبح "البيانات" حقائق إلا حين يُعاد تأويلها عبر سياقها، وتُربط بفرضيات، وتُختبر بمعايير متعددة.

رابعًا: ما الذي يجعل البيانات صالحة للحقيقة؟

ليست كل البيانات متساوية في قابليتها لأن تُفسّر. ولكي تقترب من الحقيقة، يجب أن تتوافر فيها:

-

الصدق (Validity): أن تقيس ما يُفترض أنها تقيسه.

-

الثبات (Reliability): أن تعطي النتائج نفسها عند التكرار.

-

التمثيل (Representativeness): أن تعكس المجتمع المستهدف.

-

الوضوح التحليلي: أن يُفهم سياقها وتُصاغ فرضياتها بدقة.

البيانات الجيدة لا تكتفي بأن تكون صحيحة عدديًا، بل يجب أن تكون مفهومة تأويليًا.

تحليل البيانات ليس نشاطًا تقنيًا معزولًا، بل هو بنية عقلية مركّبة تدمج بين الرؤية المنهجية، والدقة الإحصائية، والحس التأويلي. الأرقام لا تُنتج الحقيقة وحدها، بل تنتظر من يُعيد بناءها، ومن يربطها بالسياق، ومن يجرؤ على اتخاذ القرار بناءً على دلالاتها. في هذا المقال، تعقبنا البيانات منذ لحظة سؤالها الأول، مرورًا بمراحل تكوينها وتنقيتها، وانتهاءً بسؤالها الأعمق: هل البيانات حقائق؟ وما تعلمناه أن أعظم تحليلات البيانات لا تعني شيئًا ما لم تُحسن سؤالها، ولا تكتسب وزنًا ما لم تُترجم إلى فعل.